那么,索引膨胀为什么会出现?

其实很多时候,是无心之过。很多企业在做内容时,并没有去考虑“这个页面是否真的值得被用户从搜索引擎找到”。

比如公司网站上的新闻稿:新员工加入、公司开年会、内部团建、获得某个行业小奖——这些事情当然有意义,但仅限于内部和已有客户,它们并不具备搜索价值。电商网站则会拥有大量生命周期极短的商品页面,这些产品可能几个月后就下架了,但 URL 却仍然被索引占位。

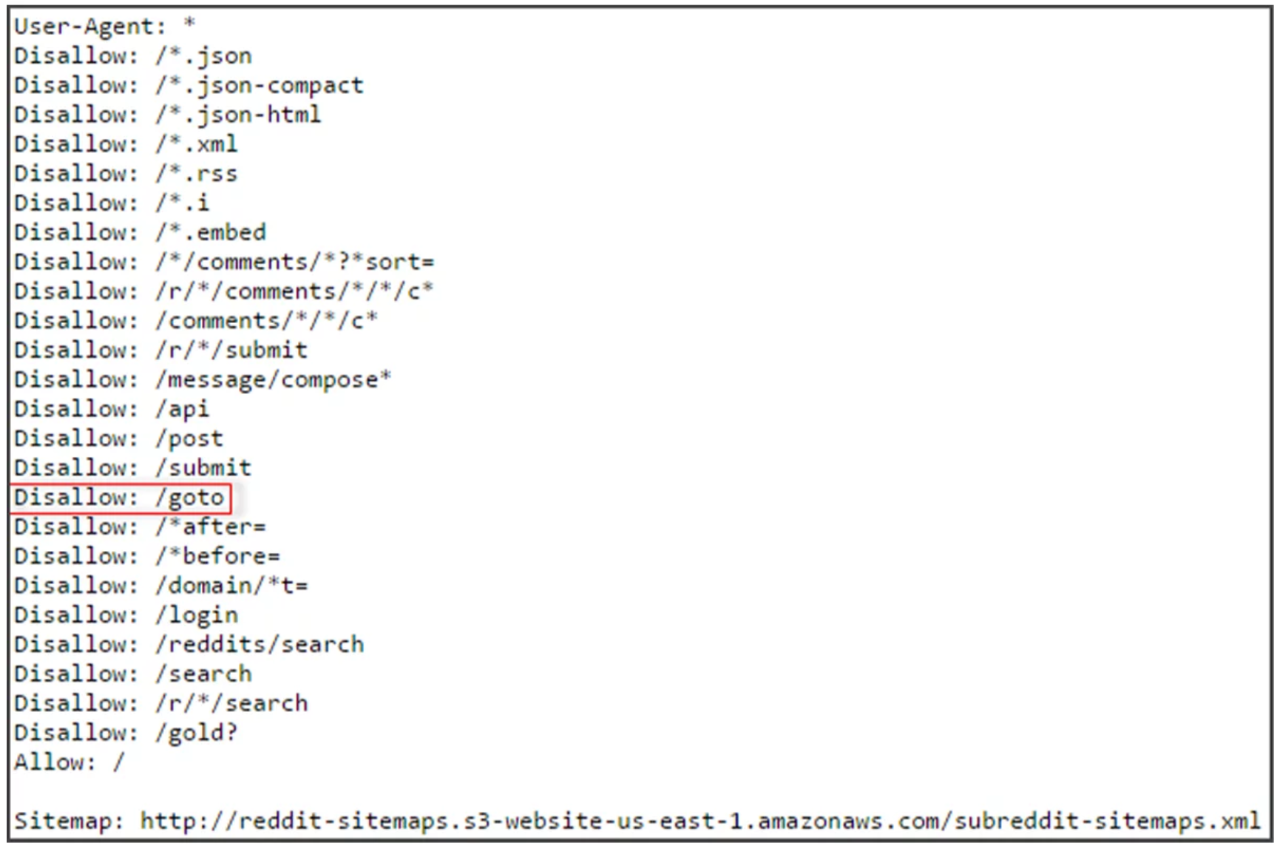

论坛、问答社区、用户投稿板块则可能积累大量重复、内容空洞、缺乏讨论的页面。再加上技术层面,参数化 URL 可以像病毒一样不断扩散,每一次排序、筛选、分页都会创造一个“看似新”的链接。

这样的网站看似内容很多,当用户浏览后发现有很多对自己没用的信息,自然就不会再信任它。

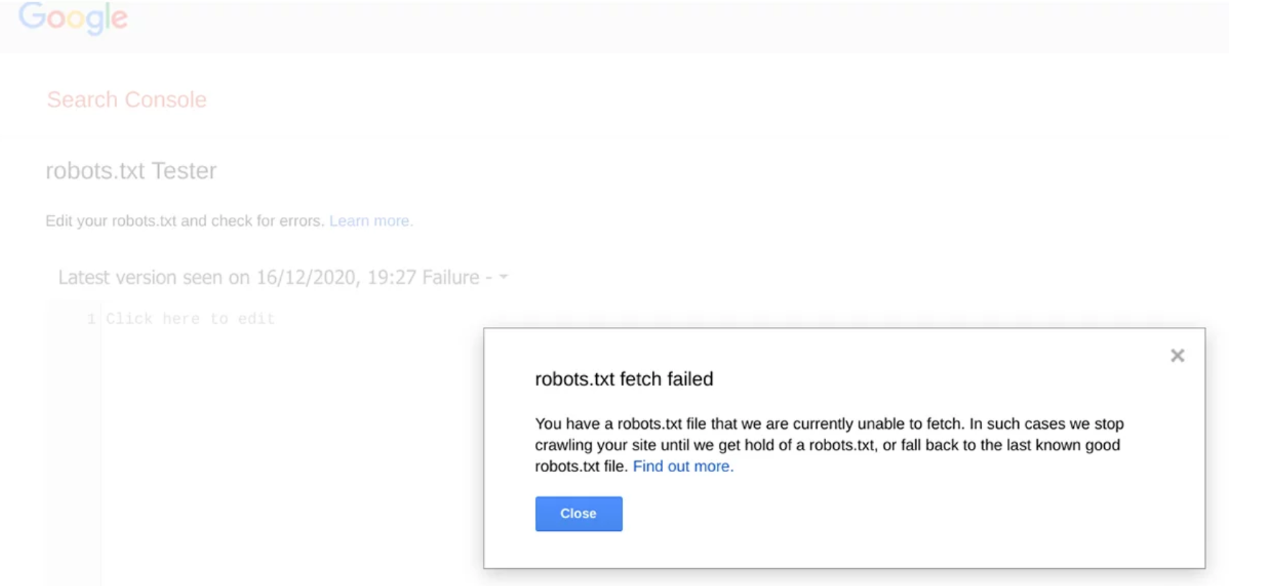

此外,缺少或未正确配置的 robots.txt 文件也会加剧索引膨胀问题。robots.txt 是放在网站根目录的文本文件,用于告诉搜索引擎哪些页面可以抓取,哪些页面应该被排除。

如果没有这个文件,或者文件配置不当,搜索引擎可能会去抓取和索引一些本不该被收录的页面,导致无效页面堆积,进一步加重索引膨胀。

当Google认为你的网站整体质量一般,就会连本来优质的内容也一起被降级。更隐秘的一点是:搜索引擎的抓取资源和权重都是有限的。当它花了大量精力去抓那些“没用的页面”,它自然就会减少在你真正优质的页面上投入。最终结果就是:权重被稀释、抓取资源被浪费、展示机会减少、流量提升无望。

而最糟糕的是:很多站长根本意识不到问题的存在。因为后台一看:收录数量在涨、页面在涨,好像网站数据都在升高。但只要打开自然流量报告,你就会发现一条扎心现实:99% 的页面根本没有被任何真实用户访问过。

当你看到这一刻,你就会明白:问题不在于你没有更多的网站内容,而在于你的网站有太多没有用的内容。

索引膨胀通过浪费抓取预算、降低网站整体质量评分和稀释内部链接权重,形成了一个多重打击,极大地限制了你网站的 SEO 成效。

抓取资源被浪费后,重要页面无法及时更新。

Googlebot 的抓取能力对每个网站都是有限配额,无效 URL 越多,资源越分散。结果就是,你刚发布的新品或经过优化的优质内容,可能无法被搜索引擎及时发现和索引,排名机会因此被拖延甚至丧失。

“低质量比例”升高,整体信任度就会下降。

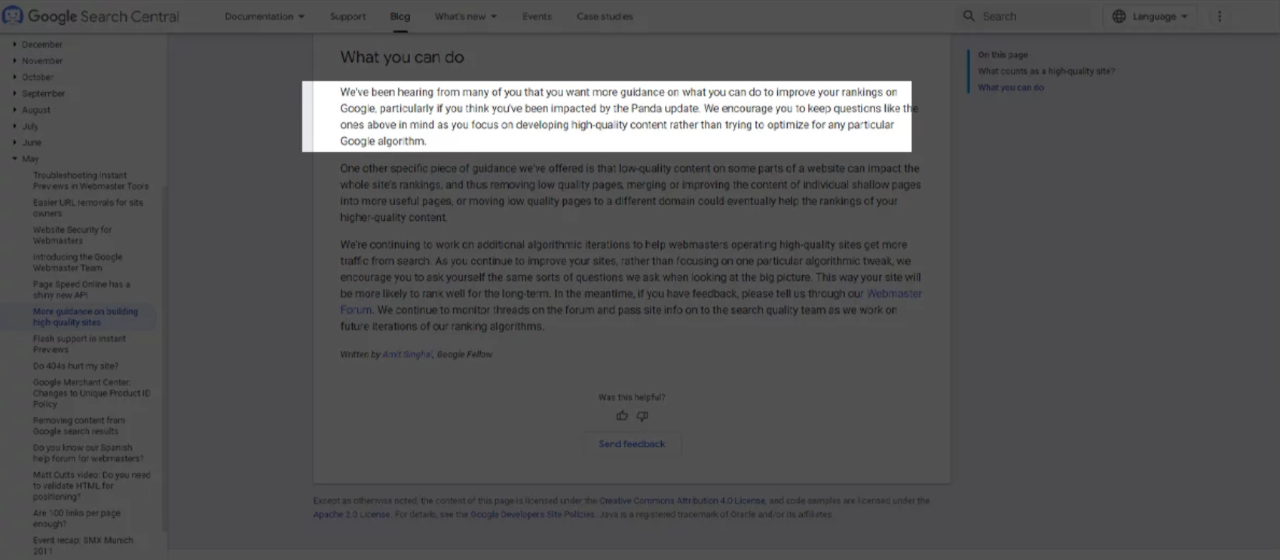

Google 的质量评估是基于整个网站的综合表现,而不是单个页面。如果网站中充斥着大量低质量页面,搜索引擎对网站的整体信任度会下降。这不仅会影响新内容的排名,还会让已有的高价值页面的排名潜力被拉低。尤其是在经历过熊猫算法(Panda)和有用内容更新(HCU)后,低质量页面的存在更加危险,可能引发算法惩罚。

索引膨胀还会导致网站内部链接的权重被稀释。每增加一个废弃或无效页面,内部链接的分布就越分散,重要页面能获得的 PageRank 权重就越少。换句话说,即使你的网站内容质量非常优秀,由于链接权重分散,核心页面的竞争力也会受到削弱,难以在搜索结果中获得应有的排名。

要判断你的网站有没有“索引膨胀”,其实就一个核心思路:

👉 Google 收录了很多页面👉 但真正能带来自然流量的页面少得可怜

这就说明,大量页面都只是躺在 Google 索引里,既没人看,也没有搜索需求,纯纯的占坑。

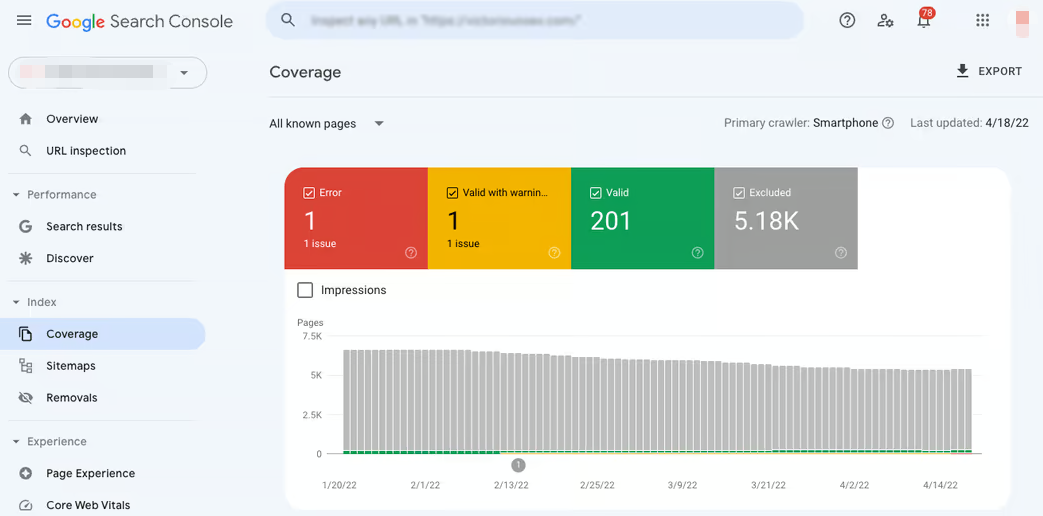

第一步,查看已索引页面数量与实际带来流量页面的比例。

打开 Google Search Console 和 Analytics,对比一下:

-

Google 说收录了好几万页面

-

但靠搜索来的流量,可能都集中在几十、几百个页面

如果是这种情况,那么大概率是索引膨胀的问题。

举个简单的例子:

-

网站有 5 万个被索引页面

-

但真正从搜索带来访问的页面不到 500 个

这种极度不匹配,会让Google认为:“你的网站大部分内容没啥价值。”

第二步,结合日志分析和抓取频率进行诊断。

有日志工具或者有SEO技术团队的话,能帮你看 Googlebot 的抓取记录。如果 Google花费大量时间抓取低质量页面,反而忽略了关键页面更新,这说明抓取预算被浪费,可能有索引膨胀问题。

第三步,结合内容质量与页面结构做细致排查。

通过网站结构审计,识别重复内容、无效分页、参数化 URL、失效产品页面等,这些通常是索引膨胀的重灾区。

索引膨胀背后的本质问题是——网站产生了大量无法贡献自然流量与搜索价值的 URL。所以,我们的处理策略非常务实:

👉 把无效页面找出来👉 能挽救的就把它变成有价值的👉 实在不行的就让它退出搜索结果

整个流程可以拆成三步 ↓

这里,我们不以“有没有收录”作为判断标准,

而以“能不能带来访问或转化”衡量价值。

判断标准包括:过去3-6个月自然点击几乎为零,没有排名或展示,缺少外链和内部链接,内容重复或过时,产品已下架或无转化可能,参数化或分页页面等。

但有些页面虽然流量低,却对社媒、邮件或广告投放很重要。这类页面不能删,建议用 noindex 标签屏蔽搜索引擎索引,保证SEO效果同时满足营销需求。

并非所有表现不佳的页面都应被放弃。许多页面之所以失效,原因可能是内容滞后、权威度不足或结构信息缺失。

对于这些仍具备主题价值或商业意义的页面,先别着急一刀切,有的页面本身方向没错,只是内容太薄、过时,或者结构没优化,这种其实是可以“救回来”的——尝试进行内容更新、意图优化、内部链接强化等提升工作。

当然,我们也可以利用 Meta Robots 标签或者 X-Robots-Tag HTTP 头部为这些页面设置“noindex, follow”的指令。这样一来,告诉搜索引擎虽然不将页面本身纳入索引,但仍允许它抓取页面上的链接。这样既避免了低质页面对整体SEO表现的拖累,又能确保网站内部权重合理传递。

与其让旧页面在索引中“躺平”,不如让它们重新成为抓取与排名竞争的一员。毕竟,在 SEO 里,“优化一个旧页面,往往比新做一个页面更划算”。

至于那些完全没有未来价值、也没任何业务意义的页面,就别拖着了。不管是通过 noindex 临时让它退出索引,还是直接清理掉,都比继续让它消耗抓取预算要健康得多。

具体怎么处理,要看页面的具体情况:

如果某些页面内容和网站上的重要页面高度相似,那么用规范标签(Canonical)指向主页面是个不错的选择,这样能告诉 Google 哪个版本才是权威,避免权重被分散。

对于已经下架或者不再销售的产品页,如果没必要保留,建议用 301 重定向跳转到相关的分类页或者新品页,这样既避免用户点进死链,也能帮助权重有效转移。

而那些彻底没用的页面,比如已经没有任何参考价值或者业务意义的,直接用 404 或 410 状态码删除,彻底从索引中剔除是最好的做法。

另外,有些页面虽然对自然搜索来说没啥用,但它们可能是配合广告投放、社交媒体活动或邮件营销特别准备的。这种情况下,最好用 noindex 标签让它们暂时不出现在搜索结果里,但依然能让用户访问,兼顾营销需求和SEO优化。

在确定哪些页面需要清理或优化之后,别忘了检查和更新你的网站的 robots.txt 文件。合理配置 robots.txt,可以有效阻止搜索引擎抓取那些无关、重复或者无价值的页面,从源头减少索引膨胀的风险。确保将不希望被搜索引擎抓取的目录和页面明确屏蔽,从而提升抓取效率和网站整体健康度。

针对不同类型的页面采取不同的处理方式,好处是Google 更专注的抓你想让它看到的页面,最终提升网站的整体表现和流量。

索引膨胀本质上是:“收录太多无效页面,让搜索引擎误判网站质量”。我们要做的,就是让 Google 更容易看到网站真正有价值的部分。这样才能让网站在全球市场中吸引更多精准买家,实现真正的流量转化和订单增长。